¿Por qué necesitamos causalidad (y por qué es difícil conseguirla)?

En la última evaluación de las pruebas PISA, los/as estudiantes de escuelas privadas mostraron mejores resultados que los/as estudiantes de escuelas públicas. Lo mismo se repitió en las pruebas Aprender de 2017. ¿Significa esto que las escuelas privadas son mejores? Una respuesta apresurada diría que sí, pero la verdad es que no hay suficiente evidencia para afirmarlo. El motivo es sencillo: no sabemos si esa diferencia se explica porque las escuelas privadas son mejores, o bien porque los/as alumnos/as de escuelas privadas son diferentes a los de escuelas públicas por otras causas —nivel educativo de los padres, nivel de ingreso familiar, posibilidades de acceso a bienes culturales—, que también podrían explicar estos resultados, independientemente de la calidad educativa.

Todo análisis causal, como evaluar si es la calidad de la escuela la que explica el resultado y no otros factores, implica un desafío. A menudo, encontramos múltiples variables que están asociadas a los fenómenos que queremos explicar, pero no es sencillo determinar si existe una relación causal. Por ejemplo, los economistas han encontrado múltiples factores que están asociados al crecimiento económico de un país, entre ellos la calidad de sus instituciones1. Sin embargo, los debates no terminan en la medida en que es difícil determinar si esa correlación implica una relación causal2.

La tarea consiste en evaluar si las relaciones que encontramos entre las variables que estamos analizando son efectivamente relaciones causales. No es sencillo de determinar. A menudo podemos encontrar en los datos correlaciones entre variables, o que con frecuencia un fenómeno es antecedido por otro, pero no es claro si esto implica una relación causal. ¿Es la calidad de las instituciones la que genera desarrollo económico, el desarrollo económico el que genera instituciones de mayor calidad, o hay una tercera variable (por ejemplo el nivel de educación de la población) la que causa al mismo tiempo que la economía crezca y que las instituciones públicas tengan mayor calidad? No es sencillo encontrar una respuesta si lo único que sabemos es que las variables están correlacionadas. Cuando era estudiante en Harvard, Tyler Vigen se dio cuenta de lo poco intuitivo que resulta ver correlaciones en datos cuando no hay relación lógicamente sostenible, y armó el sitio web Spureous correlations. En el sitio podemos ver gráficos que muestran la alta correlación entre las ventas de margarina y la cantidad de divorcios, entre la cantidad de muertos ahogados en una pileta con la cantidad de películas en las que aparece Nicolas Cage o entre la cantidad de ventas en ebay y la cantidad de vuelos espaciales rusos. Sin embargo, sería equivocado concluir, por ejemplo, que ebay planifique sus ventas mirando el plan espacial ruso. Los datos hablan todo el tiempo, pero no siempre hay que escucharlos.

El “Gold Standard”: estudios experimentales

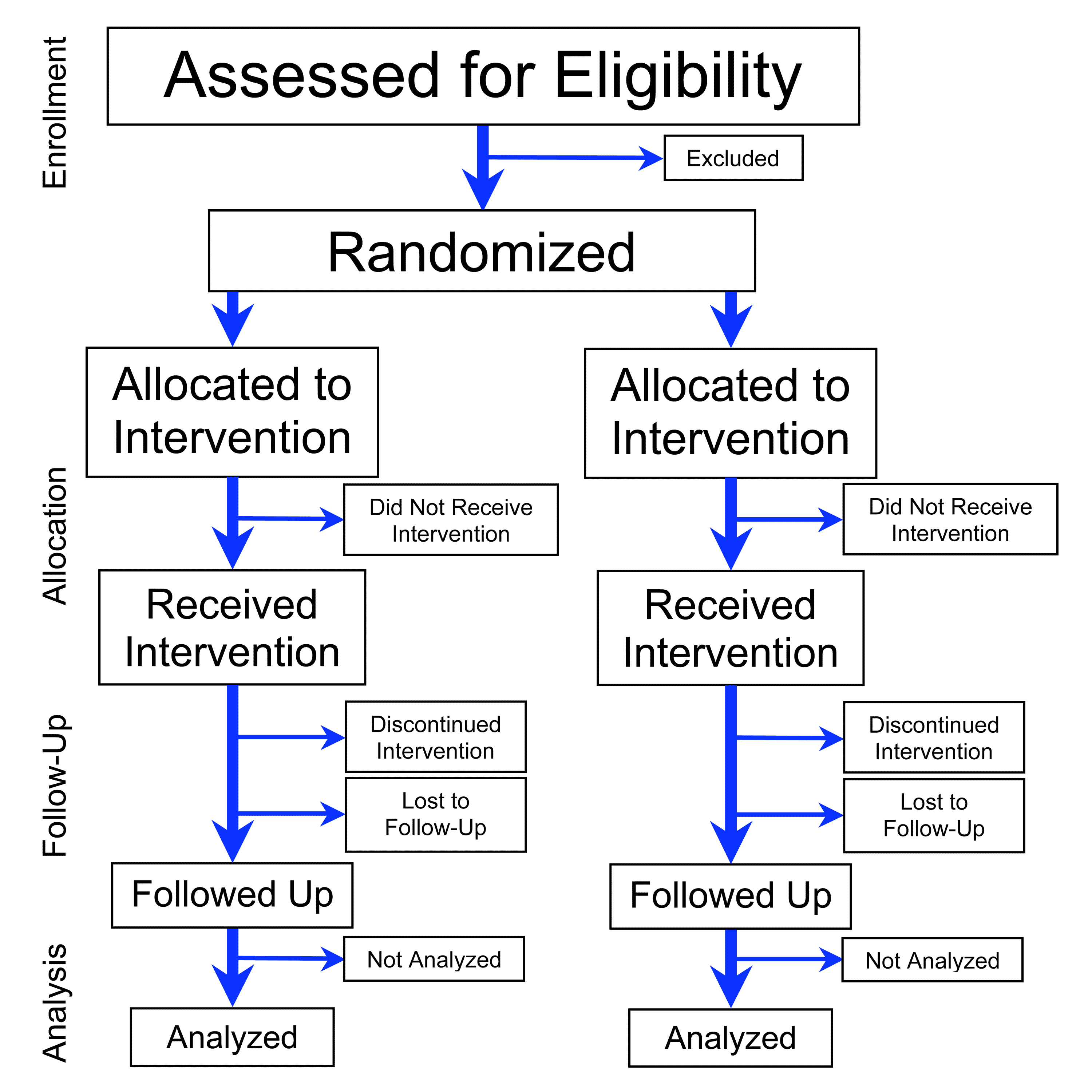

La forma más efectiva de determinar si una relación entre variables es causal, la forma adoptada por la mayoría de las ciencias, es a través de un experimento. El experimento permite manipular una variable de interés (el “tratamiento”) para observar y comparar el efecto de dicha manipulación en (al menos) dos grupos similares en todas las otras variables que también podrían incidir en el resultado. La igualación de los grupos vía selección al azar de los participantes, en la medida en que dichos grupos sean lo suficientemente grandes, permite evaluar si existe una diferencia (estadísticamente significativa) entre ambos grupos.

De este modo evaluamos, con mayor certeza, si la variable de interés genera un impacto en un resultado. y, por ende, si existe efectivamente una relación causal. Tal es el prestigio que han adquirido estos métodos que varios de los economistas recientemente galardonados con el Premio Nobel, como Abhijit Banerjee, Esther Duflo y Michael Kremer (2019) y David Card, Joshua Angrist y Guido Imbens (2021), se han dedicado al uso de métodos experimentales o cuasiexperimentales para identificar los efectos de alguna intervención.

Un razonamiento análogo está detrás de la idea del Test A/B. El uso del Test A/B en la práctica se puede remontar a los inicios de Amazon. El ingeniero Greg Linden cuenta en su blog cómo, en los inicios de la empresa, debían decidir si incorporarían la idea de un recomendador. El recomendador estaría encargado de sugerir, por ejemplo, la compra de baterías a alguien que haya adquirido un juguete. La ventaja es obvia: la posibilidad de vender más (lo que usualmente se llama cross-selling). La desventaja es la conversión, es decir que no se completara la venta. La persona que había decidido comprar podría dudar de la compra, ser llevado a otra página, buscar precios, etc.

En ese momento, el problema de la conversión era clave para Amazon, y por ese motivo la decisión fue no incorporar el sistema la figura del recomendador en una primera instancia. Sin embargo, se propuso hacer esta “prueba” al mejor estilo científico: derivar a los compradores, al azar, a dos sitios distintos, uno con recomendador y otro sin. Es lo más parecido a una prueba científica. El experimento fue increíblemente exitoso y así es como ahora tenemos recomendadores en todos los sitios de comercio electrónico.

Los estudios experimentales (conocidos como randomized controlled trials) se han utilizado, entre otros fines, para testear la efectividad de las vacunas contra el COVID-19. Los/las investigadores/as asignan aleatoriamente voluntarios a un grupo de tratamiento (quienes reciben la vacuna) o a un grupo de control (quienes reciben un placebo). La diferencia en la tasa de contagios entre ambos grupos es la medida de efectividad de la vacuna. El procedimiento de aleatorización —escoger al azar quiénes recibirán la vacuna y quiénes el placebo— garantiza que no haya sesgos de parte del/de la investigador/a al seleccionar a los participantes, ya que estos podrían incidir en el resultado.

La estadística clásica está pobremente equipada para tratar con estas situaciones. No existe una notación o forma de distinguir los datos observados de los datos sobre los que se actúa. Sin embargo, son situaciones muy diferentes y parece haber un consenso entre los/as investigadores/as de diversos campos: siempre que sea posible, la manera más efectiva de evaluar el impacto de una intervención es a través de un diseño experimental.

Dos enfoques frente a la causalidad

Naturalmente, no todas las preguntas que nos hacemos pueden ser dilucidadas a través de diseños experimentales. ¿Es posible evaluar la existencia de relaciones causales cuando la evidencia recogida no ha sido sometida a un diseño experimental?

Tomemos una conocida controversia sobre la incidencia del cigarrillo en la probabilidad de contraer cáncer de pulmón. Ronald Fisher, uno de los padres de la estadística moderna, se manifestó crítico de los primeros estudios que afirmaban que existía una relación causal entre el hábito de fumar y la probabilidad de tener cáncer de pulmón. En una ya célebre columna, Fisher afirmó que en los estudios no experimentales era difícil determinar las implicancias de una correlación hallada entre las variables “A” y “B”, si la causa de dicha correlación residía en que A determinaba B, que B determinaba A, o que existía una tercera variable que determinaba al mismo tiempo A y B. En particular, consideraba que tanto la predisposición a fumar como la predisposición al cáncer podrían tener causas genéticas.

Fisher no era el único en sostener este tipo de hipótesis, incluso el presidente de la American Cancer Society, Charles Cameron, sostenía que diferencias hormonales podrían generar al mismo tiempo predisposición a fumar y predisposición al cáncer .

Junto con otros bioestadísticos como Joseph Berkson, Fisher se convirtió en un fuerte crítico de los primeros estudios que mostraban una relación entre el cáncer de pulmón y el cigarrillo. Ambos eran fervientes defensores de los randomized controlled trials como método para identificar relaciones causales. Tal como afirmaba Berkson, “la consideración más importante respecto a una teoría no es si la misma resulta plausible, sino si permite realizar un experimento y qué tipo de experimento permite realizar”3.

De igual modo, en los años ’70, un creciente número de estudios encontraba una relación estadísticamente significativa entre el hábito de fumar por parte de las madres, y el bajo peso al momento del nacimiento, o incluso la probabilidad de muerte en el parto. Sin embargo, algunos detractores de esas teorías, como Jacob Yerushalamy, bioestadístico de la Universidad de Berkeley, afirmaban que no podía descartarse que hubiera otros factores constitutivos del organismo que generaran al mismo tiempo una predisposición a fumar y predisposición al bajo peso en el momento del nacimiento4.

Sin embargo no era esta la única posición que imperaba entre los bioestadísticos. Otros/as investigadores/as argumentaban que la integración de diversos cuerpos de evidencia de estudios no necesariamente experimentales podían ayudar a establecer relaciones causales. Por ejemplo, Abraham Lilienfeld afirmaba que “la plausibilidad de una hipótesis causal no debe evaluarse en términos de un único estudio o ‘experimento crucial’, sino en términos de la totalidad de la evidencia biológica disponible”5 .

Una discusión análoga podemos encontrar en el terreno de la evaluación de políticas públicas, más específicamente, en la creciente tendencia al uso de evaluaciones basadas en evidencias. Los randomized controlled trials y los experimentos de campo (randomized field experiments) han sido considerados el gold standard en este terreno por la posibilidad que tienen de medir efectivamente el impacto de una intervención pública a través de la creación de dos grupos comparables.

Organizaciones como J-PAL (MIT) e Innovations for Policy Actions han desarrollado múltiples estudios con diseños aleatorizados para conocer el impacto de diversos tipos de intervenciones. Estos diseños pueden proveer, en teoría, “evidencia dura” que ha de ser considerada superior a la evidencia provista por otro tipo de estudios observacionales. Así lo considera el Premio Nobel de Economía 2019 Abhijit Banerjee6: “no deberíamos gastar mucho dinero en una intervención sin haber hecho al menos un estudio aleatorizado exitoso en caso de que pueda hacerse”.

Sin embargo, no siempre es posible contar con un diseño aleatorizado para la toma de decisiones. Tal exigencia implicaría poner en el primer plano de la toma de decisiones la posibilidad de encontrar áreas en las que la intervención pueda ser testeada con diseños experimentales, lo cual no es necesariamente sinónimo de relevancia para las políticas públicas7. En ocasiones, es necesario tomar decisiones sin contar con evidencias producidas por el gold standard, como ocurrió en tiempos de pandemia8.

Pensemos esta situación hipotética. Si deseamos estudiar el efecto que la malnutrición puede tener en el rendimiento escolar de los/as estudiantes, ¿deberíamos designar aleatoriamente a algunos/as de ellos/as para exponerlos/las a una mala alimentación? Eso obviamente no sería ético. Incluso, los hallazgos de los estudios experimentales en contextos específicos no necesariamente serán similares en otros contextos9. Por ello la idea de que solamente el conocimiento es generado por estudios aleatorizados ha sido criticada por diversos autores10.

En suma, no todo lo que deseamos conocer puede ser sometido a un diseño experimental, ya sea por motivos éticos (no debemos intervenir sobre los individuos para testear algo que puede ser nocivo o perjudicial ) o prácticos. ¿Qué hacer cuando el fenómeno que se desea examinar no puede ser sometido a un diseño experimental?

El dilema se torna más acuciante en el campo de las políticas públicas, ya que muchas veces debemos actuar aún con evidencia incompleta11. Una actitud excesivamente cauta en arribar a conclusiones a partir de asociaciones halladas en forma no experimental puede ser paralizante. Parálisis que puede llevarnos a decisiones equivocadas, por ejemplo, la no intervención pública en una campaña contra el cigarrillo que, como sabemos ahora, puede salvar vidas.

La mayoría de las decisiones que debemos tomar no se basan en situaciones en las que podemos manipular las intervenciones que estamos estudiando, aleatorizar y, por ende, experimentar. ¿Qué hacer, entonces, cuando necesitamos tomar decisiones y no contamos con el diseño “ideal” (aleatorizado) para apoyarnos?

La búsqueda de causalidad fuera de los diseños experimentales

El primer camino que de forma más cercana replica al diseño aleatorizado es lo que llamamos un “experimento natural”. Este método intenta recrear diseños de tipo experimental en situaciones en las que el tratamiento no puede ser manipulado. En esencia, se busca identificar situaciones que recrean “naturalmente” un diseño experimental.

Por ejemplo, Galiani y Schargrodsky se propusieron investigar en qué medida otorgar derechos de propiedad a los residentes sobre el lugar en el que viven tiene un impacto positivo sobre el bienestar y progreso de las poblaciones más desfavorecidas. Para ello, explotan un experimento natural a partir de un proceso de ocupación de tierras en el conurbano bonaerense en 1981.La ocupación en tierras privadas llevó a un grupo de antiguos propietarios a iniciar una demanda, mientras que otros aceptaron una compensación monetaria por parte del gobierno. Como resultado de este proceso algunos ocupantes lograron obtener el título de propiedad. Otros no. La adquisición del título estuvo relacionada con decisiones de los propietarios y no con iniciativas de los ocupantes o con características del terreno, por lo que se puede considerar una asignación aleatoria de títulos de propiedad. Es decir, un experimento natural. Como resultado, los autores observaron que en los hogares que habían obtenido título de propiedad se incrementó la inversión en vivienda, tendió a decrecer la cantidad de hijos/as por hogar (un promedio de 6 en los hogares sin título y de 5 en los hogares con título) y aumentó la escolarización (la probabilidad de que un hijo/a completara la escuela secundaria aumenta en 27 puntos porcentuales en los hogares con título).

En otra investigación, uno de los ganadores del Premio Nobel de Economía del 2021, David Card, junto con Alan Krueger, estudiaron si un aumento del salario mínimo causa un descenso en la tasa de empleo. Para hacerlo, utilizaron un diseño cuasiexperimental comparando dos jurisdicciones de los Estados Unidos. En 1992 Nueva Jersey introdujo una suba en el salario mínimo. Según lo que afirmaban las teorías predominantes de la economía, dicha suba debería haber generado un aumento del desempleo, en tanto menos empleadores estarían dispuestos a contratar a un salario más alto. Los autores evaluaron el efecto de tal suba comparando el nivel de empleo de los restaurantes de ese Estado con el de su vecino Pennsylvania, que no había introducido ningún cambio. Utilizaron una estrategia de Diferencias en Diferencias: estimaron la diferencia entre el nivel de empleo en el Estado “tratado” (Nueva Jersey) luego de la suba del salario mínimo relativo al nivel de empleo previo a la medida, con respecto a la diferencia en el Estado “control” (Pennsylvania) entre similares períodos. Encontraron que, en contra de lo esperado, una suba del salario mínimo no generó mayor desempleo.

Otras técnicas estadísticas cuasiexperimentales (como el matching, el uso de variables instrumentales, o las regresiones discontinuas) también permiten recrear las condiciones experimentales para estimar efectos causales. Además se han desarrollado otros modelos para estimar efectos causales, como los “árboles causales” o el cálculo causal de Judea Pearl12.

Conclusiones: un enfoque pragmático para el uso de datos

La evidencia válida no debe pensarse como un umbral único, determinado solo por si el diseño se puede aleatorizar o no, que define si los datos puedan ser utilizados o deban ser desechados13. Todos los datos que podamos obtener sobre el fenómeno que deseamos conocer probablemente contengan algún tipo de información que puede sernos de utilidad. Por eso, no deben ser desestimados (aun si provienen de diseños no aleatorizados). Debemos utilizar los datos que podamos obtener siempre teniendo en cuenta que cualquier conclusión que tomemos sobre la base del uso de datos implica un determinado nivel de incertidumbre.

Ser conscientes de los niveles de incertidumbre con los que manejamos los datos nos ayuda a darles un mejor uso. Tener claro que los datos pocas veces nos van a dar total certidumbre permite ser más efectivos al incorporarlos a la toma de decisiones. Aun en los diseños aleatorizados, cualquier inferencia que hagamos implica un nivel de incertidumbre. Por ejemplo, ¿en qué medida los resultados obtenidos en el contexto estudiado serán válidos en otros contextos?14. Esta incertidumbre puede provenir también de otros frentes, como las dificultades de medición (saber si estoy midiendo efectivamente aquellos que me propongo medir) o problemas asociados al diseño del experimento (como la contaminación por ejemplo).

Tomar decisiones sobre la base de evidencia no debe implicar una parálisis dada por ignorar datos que provengan de un diseño “ideal”. Por el contrario, implica hacer un uso eficiente de la experiencia, de las observaciones, de los datos en suma, para que estos nos ayuden de la mejor forma posible en la toma de decisiones.

Sin datos, la toma de decisiones tiene más riesgo de caer bajo el sesgo de nuestras propias preferencias, creencias y prejuicios. Nuestras propias creencias se traducen en eslóganes o dogmas que resuenan y muchas veces nos llevan a decidir ignorando una realidad que podríamos ver mirando datos reales y concretos.

Mucho más efectivo que el escepticismo es volver a la visión práctica: analicemos los datos y busquemos indicios. Nos podremos equivocar, pero nos vamos a equivocar menos que si prescindimos de los datos. Una evidencia incompleta es mejor que un excelente eslogan.

1 Ver por ejemplo Dani Rodrik., A. Subramanian, and F. Trebbi, “Institutions Rule: The Primacy of Institutions over Geography and Integration in Economic Development,” Journal of Economic Growth 9 (2004): 131–165.

2 Janine Aron, “Growth and institutions: a review of evidence,”The World Bank Research Observer 15, No. 1 (Febrero 2000): 99-135.

3 J. Berkson, “Smoking and lung cancer: some observations on two recent reports,” Journal of American Statistical Association 53 (1958): 28-38, citado en Mark Parascandola, “Two approaches to etiology: the debate over smoking and lung cancer in the 1950s,” Endeavour 28, No. 2 (Junio 2004): 81-86.

4 Mark Parascandola, “Two approaches to etiology: the debate over smoking and lung cancer in the 1950s,” Endeavour 28, No. 2 (Junio 2004): 82.

5 A.M. Lilienfeld, “On the methodology of investigations of etiological factors in chronic diseases – some comments”, Journal of Chronic Diseases 10 (1959): 41-46, citado en Parascandola, “Two approaches to etiology”, 81-86.

6 Abhijit V. Banerjee, Making Aid Work, (Cambridge: MIT Press, 2007), 12.

7 Justin O. Pakhurst, “Appeals to evidence for the resolution of wicked problems: the origins and mechanisms of evidentiary bias,” Poliscy Sci 49 (2016): 124.

8Kaifeng Yang, “What Can Covid-19 Tell us about Evidence-Based Management?”, American Review of Public Administration 50, no. 6-7, (Agosto 2020): 706-12.

9 Dani Rodrik, “The New Development Economics: We Shall Experiment, but How Shall We Learn?,” HKS Faculty Research Working Paper Series RWP 08-055 (Octubre 2008).

10 John Gerring, “How good is good enough? A multi-dimensional, best possible standard for research design,” Political Research Quarterly 64, No. 3: 625-636; Rodrik, “The New Development Economics”.

11Para un ejemplo reciente sobre la toma de decisiones relativa al cierre de escuelas y trasmisión del COVID en la Ciudad de Buenos Aires ver Daniel Yankelevich y Alejandro Avenburg, “Tomar decisiones en pandemia: la insoportable levedad de la evidencia,” El DiarioAr,1 de Junio, 2021, https://www.eldiarioar.com/opinion/decisiones-pandemia-insoportable-levedad-evidencia_129_7989761.html.

12 Pearl genera una nueva notación (denominada “do”) para introducir la idea de que un investigador puede manipular la variable para forzar a que tenga un determinado valor, es decir, introduciendo la idea de que el investigador puede manipular una variable y eso requiere una notación específica. Asimismo, el autor desarrolló los directed acyclic graphs para diseñar de manera gráfica las relaciones causales aceptadas (hipotetizadas) entre variables. Al respecto ver Judea Pearl y Dana Mackenzie, The Book of Why: The New Science of Cause and Effect (Basic Books: 2018); Judea Pearl, Causality: Models, Reasoning and Inference (Cambridge: Cambridge University Press, 2000).

13 Gerring, “How good is good enough,” 625-636.

14 Rodrik, “The New Development Economics.”